11/2022

Vorschläge zur wirksameren Durchsetzung des Datenschutzrechts

2.4 Verbreitung und praktische Relevanz

2.4.1 NFP75-Daten zur Verbreitung in der Schweiz

Im zweiten Modul des NFP75-Projekts wurde mit einer Online-Umfrage systematisch die gegenwärtige Verbreitung von People Analytics in der Schweiz erforscht. Die Online-Umfrage ergibt, dass knapp zwei Drittel der befragten Schweizer Unternehmen People Analytics verwenden (65 Prozent oder 102 von 158 Betrieben).

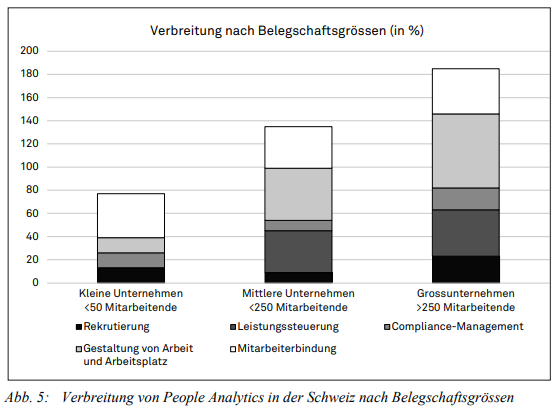

Bei grösseren Unternehmen ist People Analytics verbreiteter als bei kleineren (siehe Abb. 5). Es ist davon auszugehen, dass die Grenzkosten für People Analytics sinken und der Nutzen von Datenbearbeitungen steigt, je grösser das Unternehmen ist. Kleine und mittlere Unternehmen werden vielfach informelle Lösungen präferieren.

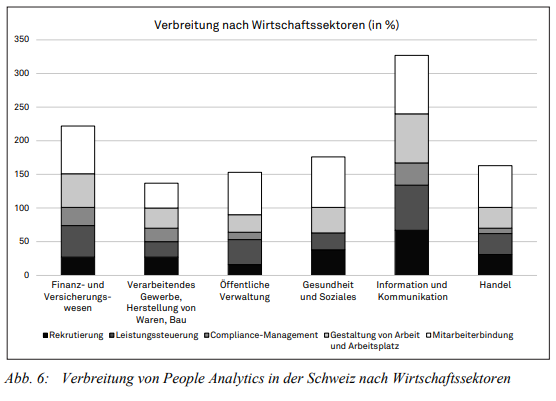

People Analytics ist in allen Schweizer Wirtschaftszweigen verbreitet (siehe Abb. 6). Führend ist der Informations- und Kommunikationssektor, gefolgt vom Finanz- und Versicherungswesen.

Die Umfrageergebnisse deuten darauf hin, dass sich People Analytics im Ausland bereits weiter als in der Schweiz entwickelt hat. Zwar wurden ausschliesslich Unternehmen mit Sitz in der Schweiz befragt, und von ihnen verwenden zwei Drittel People Analytics (66 Prozent). Jedoch hebt sich von diesem Durchschnitt eine kleine Gruppe von Unternehmen ab, die zu einem Konzern mit Hauptsitz im Raum USA und Kanada gehören: Alle von ihnen setzen People Analytics ein (100 Prozent).

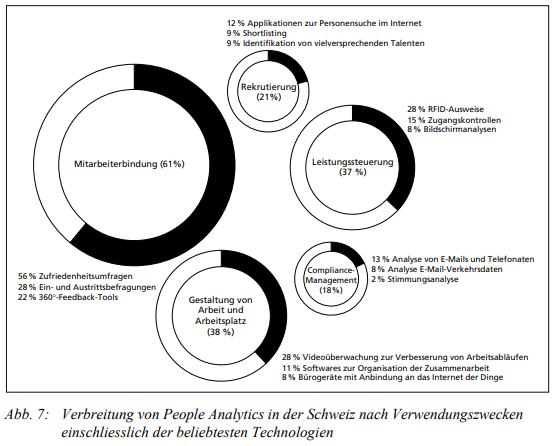

Es resultiert folgende Verbreitung nach Verwendungszwecken von People Analytics (siehe Abb. 7): Am häufigsten ist die Nutzung von People Analytics im Bereich der Mitarbeiterbindung (61 Prozent). Hier kommen Online-Befragungen zur Zufriedenheit der Arbeitnehmenden vor, um das Betriebsklima zu verbessern.

Auch gibt es zur Verbesserung der Feedback-Qualität Smartphone-Applikationen, die eine 360°-Rückmeldung von Arbeitskollegen, Vorgesetzten und Kunden ermöglichen. Bereits seit Längerem bekannt sind computerbasierte Austrittsbefragungen, um die Personalpolitik anzupassen. Zur Gestaltung der Arbeit und des Arbeitsplatzes (38 Prozent) sowie zur Leistungssteuerung (37 Prozent) findet People Analytics ungefähr gleich oft Anwendung. Im ersten Fall existieren zum Beispiel Video-Überwachungsanlagen zur Verbesserung der Arbeitsabläufe oder Softwares zur erleichterten Zusammenarbeit im Team, wie u.a. eine Software, die Stimmen erkennt und die Webcam in virtuellen Teamsitzungen steuert. Im letztgenannten Fall treten RFID-Ausweise zur Geolokalisierung und elektronische Zugangskontrollen auf. Ungefähr jedes fünfte Unternehmen, das People Analytics einsetzt, ist im Bereich der Rekrutierung aktiv (21 Prozent). Die Arbeitgeber nutzen vor allem Anwendungen, die automatische Suchprozesse und einen Abgleich (matching) von Fähigkeiten der Bewerber mit Stellenanforderungen ermöglichen.Ähnlich viele (18 Prozent) verwenden People Analytics für das Compliance-Management, etwa zur Auswertung von Telefonaten und E-Mails.

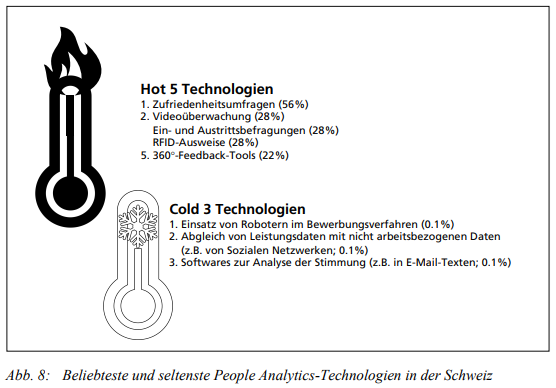

Die beliebtesten Instrumente sind in dieser Reihenfolge: webbasierte Zufriedenheitsumfragen, Video-Überwachungsanalagen, Austrittsbefragungen, RFID-Aus-weise und Feedbackinstrumente. Demgegenüber kaum genutzt werden derzeit Roboter zur Rekrutierung oder Stimmungsanalysen (siehe Abb. 8). Im Vergleich zu den Beispielen aus Literatur und Presse erweisen sich die beobachteten Datenanalysen als eher konservativ. Allerdings könnten die Daten zu neuen Zwecken wiederverwertet werden, wodurch der Grad an Einsicht in das Leben des Arbeitnehmers steigen würde. Beispielsweise verraten die elektronischen Ausweise Bewegungsmuster und Verhaltensprofile, wenn die Arbeitnehmer während der Arbeitszeit mehrfach ihren Aufenthaltsort wechseln und dabei immer wieder Zutrittsschranken passieren müssen.

Die meisten Unternehmen begnügen sich nicht mit einer einzigen der erwähnten Techniken. Knapp die Hälfte (46 Prozent) aller befragten Unternehmen hat parallel mindestens drei verschiedene Anwendungsformen von People Analytics im Einsatz. Bei jedem vierten (27 Prozent) aller befragten Unternehmen sind es mindestens fünf. Vier befragte Unternehmen geben an, zehn oder mehr Tools gleichzeitig im Einsatz zu haben.

2.4.2 Verbreitung in der Welt

Die Zahlen, die im NFP75-Projekt über People Analytics im schweizerischen Arbeitsmarkt erhoben wurden, bilden keine Ausnahme im Vergleich zu den Zahlen zur gegenwärtigen Verbreitung in der restlichen Welt, welche in der Literatur zu finden sind. Die technologiebasierte Überwachung und Kontrolle der Arbeitnehmenden wird sowohl auf der nördlichen als auch auf der südlichen Hemisphäre praktiziert. Im Jahr 2014 gab jedes vierte (26 Prozent) befragte deutsche Unternehmen in einer Umfrage an, People Analytics zu betreiben. 2015 nutzte bereits fast jedes dritte (32 Prozent) der weltweit befragten Unternehmen Big Data zur Unterstützung des Personalbereichs. People Analytics wird auch von öffentlich-rechtlichen Arbeitgebern betrieben.

Vorliegend wurden entlang dem Mitarbeiter-Lebenszyklus fünf Zwecke von People Analytics identifiziert, nämlich Rekrutierung, Leistungssteuerung, Compliance-Management, Arbeits- und Arbeitsplatzgestaltung sowie Mitarbeiterbindung. Hinsichtlich der Bewerbungsphase ist bekannt, dass in den USA und Grossbritannien bis zu 70 Prozent der Bewerber automatisiert von algorithmischen Entscheidungssystemen bewertet und vorausgewählt werden, bevor ein Rekrutierer sich die verbliebenen Kandidaten ansieht. Erst jedoch jedes zwanzigste deutsche Grossunternehmen (6 Prozent) benutzt vergleichbare Verfahren. Auch in der Schweiz kommt das sog. Hiring by Algorithm oder E-Recruiting vor.

Im Bereich der Leistungssteuerung verfolgten 2012 knapp zwei Drittel (62 Pro-zent) der Firmen ihre Aussendienstmitarbeiter über GPS. In jedem fünften europäischen Unternehmen (18 Prozent) benutzten Arbeitnehmer 2015 Wearables zu Arbeitszwecken. Die Verbreitung von Wearables ist aber, gemessen an ihrem Potenzial, noch bescheiden. Wearables können in Gesundheitsprogrammen verwendet werden. Diese wiederum kommen in den USA in Grossunternehmen flächendeckend vor.

Zur Compliance-Überwachung kontrollierte schon 2002 jede fünfte Schweizer Arbeitgeberin (18 Prozent) die E-Mails ihrer Angestellten. Zur gleichen Zeit überwachten bereits drei Mal so viele amerikanische Arbeitgeberinnen die Internetnutzung ihrer Arbeitnehmer. 2010 verfolgten drei von vier US-Arbeitgeberinnen (75 Prozent) die Kommunikation der Mitarbeiter und andere Arbeitstätigkeiten. Heute überwachen in den USA und in Grossbritannien praktisch alle (98 Prozent) Grossunternehmen digitale Aktivitäten der Angestellten. Auch bestimmen mittlerweile biometrische Fingerabdrücke, Gesichtserkennung und Iris-Scans in fast zwei von drei Unternehmen (62 Prozent), wer Zugang zu Gebäuden erhält.

2.4.3 Steigende künftige Verbreitung

People Analytics ist eine relativ junge Disziplin, deren Anfänge auf die 2000er-Jahre zurückdatieren. Aufgrund der gestiegenen Zahlen der Vergangenheit ist anzunehmen, dass People Analytics auch künftig für die Unternehmensführung an Bedeutung zulegen wird. Gewichtige Anbieter wie SAP, IBM, HP, Oracle und weitere investieren grosszügig in die Entwicklung von Analytik-Produkten. Auf der Nachfrageseite entstehen neue Stellenprofile, wie beispielsweise der Data Scientist, Datenanalyst, People Analytics Leader oder Chief Operating Officer of Culture. Prognosen gehen von einem Marktwachstum in Milliardenhöhe aus. Die Beobachtungen in der Nische People Analytics stehen vor dem Hintergrund einer Reihe von Trends – sog. Megatrends –, die die Gesellschaft in grossem Stil tiefgreifend verändern. Es ist nun zu zeigen, wie einige dieser Megatrends People Analytics tragen.

Durch die Globalisierung entsteht ein erdumspannender Wettbewerb, in dem die Talente mobil sind. Sie sind besser informiert über die Vorteile anderer Arbeitgeber. Der Aufwand steigt, um die Talente anzuziehen und zu behalten. Als Reaktion darauf schneiden die Unternehmen die Mitarbeiterführung mithilfe von Analytik auf den Einzelnen zu (workforce of one) durch Anbieten personalisierter Dienstleistungen wie gegenüber Kunden (consumerisation of HR).

Eine jüngere Facette der Globalisierung zeigt sich in stärker wissensbasierten Prozessen, geschürt durch das Internet als Informationsmedium. In dieser Wissensgesellschaft erblüht der Dienstleistungssektor, der mittlerweile die Mehrheit der Bevölkerung beschäftigt. Routineaufgaben entfallen durch Automatisierung; komplexe Spezialistentätigkeiten erfordern ausgebildete Fachkräfte und menschliche Kreativität. Für die Arbeitgeberin ist es wichtig, dass sie die individuellen Stärken ihrer Angestellten gründlich kennt.

Wegen des demografischen Wandels, der eine Alterung und Schrumpfung der arbeitenden Bevölkerung mit sich bringt, wird sich der Fachkräftemangel zuspitzen. Dies erfordert eine effiziente Steuerung der knappen Arbeitskräfte. Denkbar ist, dass der Stress am Arbeitsplatz zunehmen wird, wenn weniger Personal die gleiche Arbeit erledigen muss. Damit könnten Stimmungsanalysen sowie das Stress- und Pausenmanagement an Bedeutung gewinnen.

Ein kultureller Wertewandel hat eingesetzt, der sich durch eine neue Vielfalt der Lebensentwürfe und den Wunsch der Individuen nach einer Work-Life-Balance und Wertschätzung auszeichnet. Wirtschafts- und Arbeitswelt sollen sich dem Menschen anpassen und nicht umgekehrt. Um aber die individuellen Wünsche zu kennen, müssen Arbeitgeberinnen hierüber Daten erheben.

Schliesslich erlangen neue Arbeitsformen neben dem Standardarbeitsvertrag auf tiefem Niveau langsam an Bedeutung: Temporäre und Teilzeitarbeitnehmer, freie Mitarbeiter sowie agiles Arbeiten unter Auflösung von Hierarchien erschweren die Kontrolle über ein Team. Auch gegenüber Arbeitnehmern im Homeoffice will die Vorgesetzte ihr Kontroll- und Weisungsrecht behalten. Dies beschwingt People Analytics insbesondere zum Zweck der Leistungskontrollen.

2.4.4 Zwischenfazit

Die Zahlen zur gegenwärtigen Verbreitung zeigen, dass People Analytics in einer Mehrheit der Schweizer Betriebe zur Realität gehört. Auch global gesehen wird People Analytics vermehrt zum festen Bestandteil der Geschäftsmodelle, wobei die Verbreitung von Land zu Land unterschiedlich weit fortgeschritten ist. Es ist jedoch davon auszugehen, dass die Verbreitung überall zunehmen wird.

Nach der hier vertretenen Einschätzung sind die Zahlen zur Verbreitung vorsichtig zu lesen. Die Ausbreitung verläuft je nach Betrieb verschieden schnell. Zudem hat People Analytics nicht für jeden Betrieb die gleiche Bedeutung. Die meisten Unternehmen existieren seit Langem und werden nur nach und nach einzelne Anwendungen in ihre bestehenden Geschäftsabläufe integrieren. People Analytics wird hier zu einer Modalität des Geschäftsmodells, gehört aber nicht zu dessen Kern. Dagegen operieren andere, vor allem jüngere Organisationen von Grund auf mit People Analytics-Daten. Zu denken ist etwa an das Taxi-Dienstleistungsunternehmen Uber, das ohne Daten über die Fahrer nicht funktionieren würde. Insgesamt resultiert aber selbst bei dieser zurückhaltenden Lesart der Statistiken eine fortgeschrittene gegenwärtige und steigende künftige Verbreitung.

2.5 Unterschiede zu älteren Überwachungsformen

2.5.1 Vorbemerkungen

Nachdem aufgrund der weiten Verbreitung von People Analytics die Relevanz des Themas in quantitativer Hinsicht erstellt ist, sind nun auch dessen qualitativ neue Aspekte herauszuarbeiten. Es ist etwas Abstand vom Phänomen zu nehmen, um es als Ganzes zu erkennen. Ein Vergleich mit älteren Überwachungsformen am Arbeitsplatz ist erforderlich (dazu sogleich). Danach sind die drei Kernelemente aufzuzeigen, durch die sich People Analytics von den früheren Formen der Überwachung am Arbeitsplatz abhebt: Es sind dies nach der hier vertretenen Auffassung die Ubiquität, die Interoperabilität und die steigende KI.

2.5.2 Geschichtliche Vorläufer der Mitarbeiterüberwachung

Die Überwachung, ob die Arbeitnehmenden die Arbeit pflichtgemäss erledigen, ist so alt wie der Arbeitsvertrag selbst. Zunächst war es die Arbeitgeberin persönlich oder ihre Stellvertreterin, die den Arbeitnehmern über die Schulter schaute. Vom britischen Philosophen und Sozialreformer Jeremy Bentham (1748–1832) stammt das «Panoptikum», ein Idealbauplan für Gefängnisse, aber auch Fabriken, welcher einer einzelnen Person erlaubt, viele Menschen aufs Mal zu überwachen. Im Mittelpunkt dieser Bauwerke steht ein Wachturm, von dem aus das gesamte Areal sichtbar ist. Weil der Beobachtungsposten des Wärters verdunkelt ist, die Arbeitsplätze aber sonnenbeschienen sind, wissen die Arbeitnehmer oder Gefängnisinsassen nie genau, ob sie gerade beobachtet werden. Überwachungspraktiken beschränkten sich aber nicht auf das Betriebsareal: Agenten der 1850 in Chicago gegründeten Detektei Pinkerton infiltrierten das Leben von Arbeitnehmern, die Arbeitgebende wegen ihrer Gewerkschaftszugehörigkeit als Bedrohung empfanden. Im Jahr 1914 gründete Henry Ford (1863–1947) eine firmeneigene soziologische Abteilung, deren Ermittler zu Hause bei den Arbeitnehmern inspizierten, ob diese den Ford-Verhaltenskodex einhielten, was Voraussetzung für den Anspruch auf gewisse Lohnbestandteile war.

Arbeitgeber griffen schon früh zu technischen Hilfsmitteln, die die Kontrolle erleichterten: Ende des 19. Jh. kamen Stoppuhren auf, mit denen die Vorgesetzten verglichen, wer wie lange für einen Arbeitsschritt benötigte. Der amerikanische Ingenieur Frederick Winslow Taylor (1856–1915) nutzte die Stoppuhr zur Begründung einer eigentlichen Arbeitswissenschaft. Um 1915 löste der flache Modern Efficiency Desk, der dem Vorgesetzten eine leichte Sicht auf die Arbeitsfläche verschaffte, den hohen Sekretär ab, hinter dem Arbeitnehmende zuvor einen gewissen Grad an Privatsphäre genossen hatten.

Bald wurde der Wert der Analyse von Datensätzen erkannt. Im Jahr 1922 konnte aufgezeigt werden, dass die systematische Auswertung des vergangenheitsbezogenen Verhaltens und des biografischen Hintergrunds dem Bauchgefühl bei der Prognose zukünftigen Verhaltens überlegen ist. In den 1990er- und frühen 2000er-Jahren setzte die amerikanische Baseballmannschaft Oakland Athletics bei der Suche nach Talenten auf objektive Statistiken statt auf Expertenmeinungen und feierte in der Folge mit von Experten als mittelmässig eingestuften Spielern sportliche Erfolge.

Spätestens seit der Verbreitung von persönlichen Computerterminals (PC) in den 1980er-Jahren setzte eine Automatisierung der Überwachung ein. Jedenfalls die Phase der Datenerhebung wurde automatisiert; die Analyse der Aufzeichnungen dürfte anfangs noch weitgehend durch Menschen erfolgt sein.

2.5.3 Drei Kernelemente von People Analytics

a) Ubiquität

Die Datenbearbeitungen sind heute allgegenwärtig (lat. ubique: überall; vgl. engl. ubiquitous computing). Erst einmal handelt es sich um eine örtliche Ubiquität:Ob der Schritt von den Grossrechnern zum PC, die Entwicklung der Smartphones und Tablets oder aber der Wechsel zur Cloud gemeint sind – sie alle bewirken eine Dezentralisierung der Datenbearbeitungen. Die Miniaturisierung trägt das ihrige dazu bei, dass die Prozessoren überall mit von der Partie sind, etwa in Form von Wearables direkt am Körper.

Die Allgegenwart der Datenbearbeitungen ist auch von zeitlicher Dimension. Die elektronische Überwachung kann rund um die Uhr stattfinden. Sie kann teilweise nicht gestoppt werden, weil die Geräte keine Ausschaltfunktion haben. Dies wird bei der RFID-Technologie augenscheinlich: Hier versorgt das Lesegerät (der Arbeitgeberin) den Transponder (des Arbeitnehmers) mit Energie, sodass dieser seine Position durchgibt. Somit entscheidet primär die Arbeitgeberin, wann sie Aufzeichnungen vornehmen möchte. Die Datenerhebung erfolgt in Echtzeit, nicht in Quartalsberichten und jährlichen Mitarbeitergesprächen. Langfristig erfassen die Analysen den gesamten Arbeitnehmer-Lebenszyklus von der Bewerbung bis zur Beendigung des Vertragsverhältnisses. Sind die Daten einmal aufgezeichnet, sind sie in der Regel verewigt. Daten werden oft nicht gelöscht, sondern immer wieder aufs Neue aufbereitet und verwertet. Es entsteht ein digitales Gedächtnis oder eine temporale Version von Benthams Panoptikum, sodass Betroffene nie sicher sein können, ob nicht gerade jemand Einsicht in lange vergessene Aufzeichnungen nimmt. Menschen müssen lernen, mit ihrer aufgezeichneten Vergangenheit zu leben und müssen vorsichtiger sein, wenn sie etwas von sich preisgeben.

In personeller Hinsicht interessiert die Auswertung ganzer Teams und Belegschaften. Dies übersteigt die Überwachung in einzelnen begründeten Fällen (wie etwa bei konkretem Verdacht, dass ein Mitarbeiter gegen rechtliche Bestimmungen verstossen hat). Die Arbeitnehmenden sind nicht nur passive Betroffene, sondern speisen oft auch selbst Daten über sich in das System ein, beispielsweise indem sie sich mit dem Chatbot Mya von L’Oréal unterhalten. Die Daten stammen des Weiteren, wie der Big Data-Aspekt variety zeigt, von Dritten und aus dem Internet. Jedermann kann über das Internet Beobachtungen vornehmen, sodass sich der Betroffene nicht einem einzigen Big Brother, sondern «abertausenden Little Brothers» ausgesetzt sieht.

Die Datenbearbeitungen durchdringen schliesslich auch inhaltlich alle Lebensbereiche (pervasiveness). Naturwissenschaftler nennen es die «Informatisierung des Alltags». Umfassende Datenbearbeitungen über das menschliche Treiben werden zur Routine im Sinne eines «passiven Monitorings», im Gegensatz zum «aktiven Tracking». Möglich wird dadurch die Erhebung von sog. kontextuellen, d.h. nicht aufgabenbezogenen Leistungsdaten, wie beispielsweise Mitarbeiterengagement, allgemeiner Gesundheitszustand oder Verhalten der Arbeitnehmer ausserhalb des Arbeitsplatzes. Selbst wenn Dienstliches und Privates nie glasklar getrennt waren, so wirft das ubiquitous computing doch die Frage der Entgrenzung und der Trennung von Beruf und Privatleben in einer neuen Qualität auf. Zu dieser Unschärfe tragen auch die Arbeitnehmer bei, wenn sie ihren Dienstcomputer nicht nur zu beruflichen Zwecken nutzen.

b) Interoperabilität

Die Datenbearbeitungs-Systeme sind zunehmend imstande, im Sinne von Interoperabilität nahtlos miteinander zusammenzuarbeiten, sodass eine Kommunikation über die Grenzen einzelner Systeme hinweg möglich ist. Interoperabilität darf dabei nicht mit Gleichheit verwechselt werden: Sind mehrere Systeme zu 100 Prozent interoperabel, können sie nach wie vor verschiedenartig sein. People Analytics verknüpft Datenquellen, die in der Vergangenheit getrennt gehalten wurden. Die Datafizierung giesst die digitalen Daten in ein Standardformat, und das Internet fungiert als Medium für den Austausch von Information. Dadurch entfallen herkömmliche Schwierigkeiten beim Zusammenführen von Dateien aus mehreren Datenbanken. Die Interoperabilität zeigt sich beispielsweise darin, dass verschiedene Gerätetypen zusammenwachsen, weil die Software für den PC auch als App für das Tablet bereitsteht. Auch wächst die Interoperabilität an der Schnittstelle zwischen Hardware und Software: Sensoren zur Datenerhebung und Analyse-Algorithmen präsentieren sich als Ensemble, beispielsweise werden Videokameras mit integrierter Gesichtserkennungs-Software verkauft.

Der Big Data-Teilaspekt variety steht sinnbildlich für die Interoperabilität. Aus der Verknüpfung von Datenquellen, die scheinbar nichts miteinander zu tun haben, beispielsweise Daten aus dem Personalbereich mit anderen Unternehmensdaten oder externen Daten, entstehen Erkenntnisse von neuer Qualität. «Rätselhaft» ist, dass auch intime Einsichten sich aus trivialen, teils generell verfügbaren Informationen speisen, etwa daraus, wie lange die Computermaus auf einem Inserat verharrt, von welcher zu welcher Webseite jemand surft oder von wo bis wo jemand im öffentlichen Verkehr fährt. Anonyme Daten bleiben nicht unbedingt namenlos, wenn sie mit anderen Daten kombiniert werden; gewählte Telefonnummern, besuchte Webseiten und E-Mail-Metadaten können genauso viele persönliche und private Informationen preisgeben wie die Inhalte der Kommunikation selbst.

c) Steigende künstliche Intelligenz

Die Entwicklung von Quantencomputern und die Nutzung der Cloud-Technologie versprechen eine exponentiell wachsende Leistungsfähigkeit von Prozessoren und Verbesserungen der Speichertechnik – gleichzeitig sacken die Preise für die Infrastruktur in sich zusammen. Sogar die Zukunft wird greifbar, denn die prädiktive Analytik konzipiert realistische Zukunftsszenarien, und präskriptive Algorithmen schlagen frühzeitig Massnahmen zur Erreichung von Unternehmenszielen vor. Die Arbeitgeberin kann somit die Zukunft antizipieren und ist dem Arbeitnehmer stets einen Schritt voraus.

Die Arbeitgeberin kann sich immer mehr auf eine autonom agierende, intelligente Infrastruktur verlassen. Selbstlernende Algorithmen nehmen über Sensoren den Menschen wahr und können sich ihm anpassen. Roboter sind imstande, komplexe, nichtrepetitive Tätigkeiten selbständig oder in enger Zusammenarbeit mit dem Menschen zu erledigen. Algorithmen übernehmen Denkarbeit und Führungsaufgaben, wie beispielsweise Risikoabschätzungen. Sie beaufsichtigen Arbeitnehmer, etwa ob diese ihre Schutzausrüstung tragen, und benachrichtigen gegebenenfalls den Vorgesetzten. Dadurch entsteht eine Umweltintelligenz (ambient intelligence), d.h., autonome intelligente Umgebungen treffen eine beispiellose Anzahl von Entscheidungen für das private und öffentliche Wohl. Tastatur und Bildschirm werden als Schnittstellen zwischen Mensch und Maschine entfallen; stattdessen wird die Umwelt selbst, gespickt mit unsichtbaren Sensoren, zu ebendieser Schnittstelle.

Algorithmen gelten als eine Quelle sozialer Ordnung. Damit ist gemeint, dass die KI das Zweipersonenverhältnis zwischen Arbeitgeberin und Arbeitnehmer beeinflusst. Das Dazwischenfunken einer dritten (wenn auch nicht rechtsfähigen) Person weckt Ängste: Selbstlernende Algorithmen, die sich verändern und ihrerseits wieder neue Algorithmen schreiben, entziehen einem die Kontrolle. Arbeitnehmende könnten durch verhaltenssteuernde Algorithmen «automatisiert» werden. Ohne zu beurteilen, wie begründet diese Sorgen sind: Recht ist eines von mehreren möglichen Mitteln zur Einwirkung auf diese Entwicklung.

2.5.4 Zwischenfazit zu den drei Kernelementen

Während die Überwachung der Leistungserbringung schon immer zum Arbeitsverhältnis gehört hat, nimmt sie durch People Analytics eine neue Dimension an. Sie zeichnet sich durch Ubiquität, Interoperabilität und steigende KI aus. D.h., die Datenbearbeitungen sind allgegenwärtig; aus dem Zusammenführen von Datensätzen resultieren neue Erkenntnisse, die früher nicht möglich waren; und die KI der Algorithmen stärkt die Stellung der Arbeitgeberin im Arbeitsvertragsverhältnis. Diese drei Kernelemente hat der Autor vorliegend herausgearbeitet basierend auf der Detailanalyse der technischen Umgebung und der Verwendungszwecke von People Analytics sowie nach einem Blick zurück auf die geschichtlichen Vorläufer der Mitarbeiterüberwachung.

Nach der hier vertretenen Auffassung, zu welcher der Autor auch aufgrund seiner empirischen Forschungserfahrung gelangt ist, finden sich die drei Kernelemente von People Analytics in der Praxis aber nicht überall gleichmässig vor. Beispielsweise der virtuelle Karriereassistent führt zwar Daten zur Arbeitsmarktentwicklung mit Daten aus dem Lebenslauf und den Zeugnissen zusammen (Interoperabilität) und errechnet daraus selbständig das Risiko, dass die betreffende Stelle der Digitalisierung zum Opfer fallen wird (steigende KI). Doch ist diese Anwendung kaum allgegenwärtig (fehlende Ubiquität), weil der Karriereassistent nicht täglich, sondern vielleicht nur einige Male pro Jahr für die berufliche Weiterorientierung konsultiert wird. Der Umstand, dass die Datenbearbeitung nicht ubiquitär erfolgt, kann für die rechtliche Beurteilung entscheidend sein, weil in der Regel umso weniger Risiken für die Persönlichkeit entstehen, je weniger Daten bearbeitet werden. Hierauf ist später zurückzukommen.

2.6 Zwischenfazit: neuartiges, weit verbreitetes Phänomen

In Kapitel 2 ist das Phänomen «People Analytics» beschrieben worden. Die Betrachtung des Daten-Lebenszyklus hat gezeigt, dass eine umfassende technische Apparatur hinter dem Forschungsgegenstand steckt. Es wurde festgestellt, dass entlang dem Arbeitnehmer-Lebenszyklus zahllose mannigfaltige Zwecke für die Verwendung von People Analytics existieren. Ausserdem hat das Phänomen bereits in weiten Teilen des Arbeitslebens Einzug gehalten und wird sich künftig zunehmend verbreiten. People Analytics ist ein neuartiges Phänomen, das sich im Unterschied zu seinen geschichtlichen Vorläufern durch Ubiquität, Interoperabilität und steigende KI auszeichnet.

Insgesamt verbleibt von der vorliegenden Phänomenbeschreibung der Eindruck, dass sich People Analytics faktisch ungehindert ausbreitet und zu immer neuen Zwecken verwendet wird. Der technologische Fortschritt ermöglicht dies. Wenn aber die Technik keine Grenzen setzt, drängt sich die Frage auf, ob das Recht wirksame Schranken zum Schutz der Betroffenen bereithält. Dieser rechtlichen Seite des Phänomens sind die folgenden Kapitel gewidmet. Es ist zunächst zu prüfen, welche Rechtsprobleme durch die beliebige Entfaltung von People Analytics entstehen (dazu sogleich).

3 Rechtsprobleme

3.1 Übersicht

Nachdem in Kapitel 2 das Phänomen People Analytics beschrieben worden ist, wenden wir uns in den folgenden Kapiteln dessen rechtlicher Seite zu. Hierfür ist mit der Eruierung der Rechtsprobleme zu beginnen. Das Grundproblem von People Analytics besteht darin, dass es zu einer Machtverschiebung von den Arbeitnehmern hin zur Arbeitgeberin kommt oder zumindest kommen kann (dazu sogleich). Daraus folgen drei Rechtsprobleme, die nacheinander dargestellt werden: Persönlichkeitsverletzungen, Diskriminierungen und die Verletzung von Mitwirkungsrechten (Unterkapitel 3.3–3.5).

3.2 Machtverschiebung als Grundproblem

Die drei dargestellten Charakteristika von People Analytics – Ubiquität, Interoperabilität und steigende künstliche Intelligenz – schaffen in ihrer Summe ein neues Problem, nämlich eine Informations- und Machtakkumulation bei der Arbeitgeberin in einem bisher nicht dagewesenen Ausmass.

Mit People Analytics hat die Arbeitgeberin die Möglichkeit, zu tiefen Grenzkosten wertschöpfende und entscheidungsrelevante Erkenntnisse zu erlangen. Wenn sie mit People Analytics ein Werkzeug zum Wissensgewinn in der Hand hält, der Arbeitnehmer dieses Werkzeug aber weder beeinflussen noch vollständig überschauen kann, führt dies zu einem Informationsgefälle. Dieses verstärkt sich durch den Skaleneffekt in Plattformmärkten, welcher bewirkt, dass die Analysekosten pro Nutzer bei steigender Nutzerzahl sinken. Der Skaleneffekt dürfte am Arbeitsplatz zwar weniger stark zum Tragen kommen als etwa bei sozialen Netzwerken mit Millionen von Nutzern, weil die wenigsten Unternehmen so viele Beschäftigte haben. In grossen Unternehmen mit zehntausenden Angestellten mag er mehr ausmachen als in kleinen und mittleren Unternehmen. Doch darf nicht vergessen werden, dass auch kleine Unternehmen, die systematisch Daten ihrer Arbeitnehmer sammeln, sich einen umfangreichen Datenschatz aufbauen können. Das Datenvolumen, das im Arbeitsverhältnis entsteht, ist gross, weil die Arbeitnehmer regelmässig einen grossen Anteil der Gesamtzeit an der Arbeit verbringen. Kaum ein anderes Rechtsverhältnis gibt Anlass zur Erhebung und Bearbeitung personenbezogener Daten verschiedenster Art in solch grossem Umfang und während so langer Zeit wie das Arbeitsverhältnis.

«Wissen ist Macht», ein Zitat des englischen Philosophen, Juristen und Staatsmannes BACON (1561–1626), bedeutet, dass aus dem Informationsungleichgewicht ein Machtgefälle folgt. Big Data vermittelt «Macht zur Vorhersage, Macht zur Gestaltung und Macht, Entscheidungen zu treffen, die das Leben der einfachen Menschen beeinflussen». Zwischen kommerziellen Datensammlern und Betroffenen besteht ein strukturelles Ungleichgewicht. Die Investitionen in die Entwicklung von Profilbildungstechnologie übersteigen diejenigen für die Entwicklung von Technologien, die die Privatsphäre schützen, um ein Vielfaches.

Die Regulierung von Informationsflüssen ist, wie aufgezeigt, eine Aufgabe des Informationsrechts. Die gerechte Zuweisung von Macht, wie sie etwa in der öffentlich-rechtlichen Gewaltenteilung zum Ausdruck kommt, ist ebenfalls eine Aufgabe des Rechts. Somit handelt es sich bei der beschriebenen Machtverschiebung zugunsten der Arbeitgeberin um ein Problem, das rechtlich gelöst werden kann.

Manche Autoren greifen zu einer Rhetorik, die geradezu einen neuen Gesellschaftsvertrag fordert. Sie stören sich am Umstand, dass einige Private durch die Informatisierung der Gesellschaft eine Machtposition erlangen, die mit der Macht staatlicher Träger vergleichbar ist, weil sie die Grundrechte anderer beeinträchtigen können. Das Datenschutzrecht, dessen Schwerpunkt ursprünglich auf der Abwehr staatlicher Eingriffe in Grundrechte lag, dient vermehrt auch dem Ausgleich zwischen privatwirtschaftlichen Interessen. Diese Argumente böten Stoff für eine rechtsphilosophische oder staatsrechtliche Abhandlung. Die vorliegenden Betrachtungen beschränken sich aber auf privatrechtliche Fragen.

Die grassierende Informations- und Machtdiskrepanz bildet gewissermassen eine Bodenströmung, die auf den ersten Blick unsichtbar bleibt. Bemerkbar wird sie an der Oberfläche, wenn den betroffenen Arbeitnehmern Rechtsgüter oder Ansprüche weggerissen werden. Namentlich drohen als rechtliche Folgeprobleme Verletzungen der Persönlichkeitsrechte, des Diskriminierungsschutzes und der Mitwirkungsrechte, wie sogleich darzulegen ist.

3.3 Persönlichkeitsverletzungen

3.3.1 Umfassender Persönlichkeitsschutz

Die Rechtsfragen, die People Analytics aufwerfen kann, drehen sich im Kern um den Persönlichkeitsschutz der Arbeitnehmer. Die Datenbearbeiter versuchen, Aussagen über Personen und ihr Verhalten zu gewinnen. Klagen der Arbeitnehmer wegen unrechtmässiger Bearbeitung von Personendaten durch die Arbeitgeberin richten sich nach dem zivilrechtlichen Schutz der Persönlichkeit (Art. 328 Abs. 1 Satz 1 OR i.V.m. Art. 328b Satz 2 OR i.V.m. Art. 15 Abs. 1 Satz 1 DSG i.V.m. Art. 28 f. ZGB; Art. 28 Abs. 2 Satz 1 E-DSG, Art. 32 Abs. 2 Satz 1 rev-DSG).

Das Gesetz enthält keine Legaldefinition des Begriffs «Persönlichkeit» (vgl. Art. 28 ZGB). Die Botschaft zu Art. 28 ZGB zählt «alle physischen, psychischen, moralischen und sozialen Werte, die einer Person kraft ihrer Existenz zukommen», zur Persönlichkeit. Für das Bundesgericht besteht die Persönlichkeit aus all dem, «was zur Individualisierung einer Person dient und im Hinblick auf die Beziehungen zwischen den einzelnen Individuen und im Rahmen der guten Sitte als schutzwürdig erscheint». Somit ist der Begriff der Persönlichkeit umfassend zu verstehen, unter Einbezug der physischen, psychischen, sozialen und seelischen Persönlichkeit.

Persönlichkeitsrechte sind diejenigen Rechte, die den infrage stehenden Persönlichkeitsaspekt schützen. Mit der Verletzung der Persönlichkeit ist notwendigerweise immer auch das betreffende Persönlichkeitsrecht verletzt. Das Gesetz spricht von einer Verletzung «der Persönlichkeit» (Art. 28 Abs. 1 ZGB) und nicht des Persönlichkeitsrechts. Vorliegend wird diese Begriffswahl fortgeführt, gemeint ist also immer auch die Missachtung des entsprechenden Rechts.

3.3.2 Ausgewählte Aspekte der Persönlichkeit

a) Privatsphäre

People Analytics tangiert hauptsächlich die Persönlichkeitsaspekte der Privatsphäre und der psychischen Integrität. Die Privatsphäre bezeichnet einen Bereich, in dem die betreffende Person frei von Anpassungsdruck in der Authentizität ihres Verhaltens, in ihrer Spontaneität sowie freien Meinungs- und Willensbildung nicht gestört wird. In diesem Bereich darf die betreffende Person sich selbst sein, darf auch etwas eigentümlich sein (lat. privatus: persönlich, einer einzelnen Person gehörig, eigen, eigentümlich).

Permanente Überwachungen können zu einem Verlust von Authentizität und Kontrolle über die Selbstdarstellung sowie zu einer Störung von Beziehungsgestaltungen führen. Dies ist etwa denkbar bei der eingangs vorgestellten Software Intelligent Edge von Microsoft, die zur Überwachung der Einhaltung von Sicherheitsrichtlinien am Arbeitsplatz pro Sekunde 27 Millionen Aufzeichnungen liefert. Eine intensive elektronische Überwachung, deren sich die überwachte Person bewusst ist, ist geeignet, sie zu einer Anpassung ihres Verhaltens zu zwingen: Ein sozialwissenschaftliches Forschungsexperiment brachte hervor, dass Arbeitnehmer mehr Geld in die Kaffeekasse im Pausenraum steckten, wenn Augäpfel das Schild, das sie zur Zahlung anhielt, zierten, um ein Gefühl des Beobachtet-Werdens zu vermitteln. Menschen beginnen, ihr Verhalten an den Analyse-Tools auszurichten, beispielsweise, um zu möglichst guten Bewertungen zu kommen. Ein authentisches Verhalten ist nur möglich, wenn man sich vor Einblicken durch andere schützen kann. Auf den Punkt gebracht: «Authentizität gedeiht nur in der Dunkelheit. Wie Sellerie.»

Die grosse Herausforderung von People Analytics ist die Bewahrung von Autonomie als Aspekt der Privatsphäre: Je mehr Wissen die Arbeitgeberin über den Arbeitnehmer hat oder zumindest Hypothesen zu seinen Eigenschaften, seinem Verhalten und seinen Bedürfnissen, desto einfacher kann sie ihn beeinflussen, beispielsweise mit personalisierten Diensten. Der Arbeitnehmer wird dadurch manipulierbar. Dies zeigt sich am Beispiel von Uber: Für den Fahrdienstvermittler ist es überlebenswichtig, jederzeit genügend Autos im Angebot zu haben. Während der Zeiten, in denen die Nachfrage tief und weniger Geld zu verdienen ist, verzichten viele Fahrer auf das Anbieten ihrer Dienstleistung. Um dieser Tendenz entgegenzuwirken, sendet Uber den Chauffeuren Nachrichten, die sie an ihr Zieleinkommen erinnern und so zum Fahren stimulieren. Während der Eingriff in die Autonomie im Uber-Beispiel begrenzt erscheinen mag, steigt das Manipulationsrisiko je nach Technik, die bei People Analytics zur Anwendung gelangt. Beispielsweise bergen Anwendungen mit starker KI ein höheres Manipulationspotenzial in sich als solche mit schwacher KI. Die prädiktive Analytik geht davon aus, dass sich Arbeitnehmer mit ähnlichen Attributen in vergleichbaren Situationen gleich verhalten. Wenn eine Arbeitgeberin einen Entscheid für alle mit einem bestimmten Profil fällt, ohne die Arbeitnehmer anzuhören, kann es sein, dass sie Entscheidungen vorwegnimmt, die der Arbeitnehmer fällen müsste. Im Extremfall führt die Annahme, dass menschliches Verhalten berechenbar sei, zur Negierung des freien Willens.

Dem Verständnis von Privatsphäre haftet etwas Subjektives an. Weltweit gesehen besteht kein Konsens bzgl. der Konkretisierung des Rechts auf Privatsphäre im digitalen Zeitalter. Pessimisten sehen das «Ende der Privatsphäre» kommen, wähnen sich gar im «Post-Privacy-Zeitalter», weil die Digitalisierung immer mehr familiäre und intime Aspekte des Lebens für Dritte zugänglich macht. Diese Angst mag bei einem rein räumlichen, eindimensionalen und mittlerweile antiquierten Verständnis von Privatsphäre, welches vom Schutz des (Grund-)Eigentums herkommt, begründet sein. Zu bedenken ist jedoch, dass sich das individuelle und gesellschaftliche Bedürfnis nach Privatsphäre über die Zeit geändert hat und ändern wird. Die neue Omnipräsenz der Datenbearbeitungen wird die gesellschaftlichen Normen und Erwartungen an die Privatsphäre beeinflussen. Das moderne Verständnis von Privatsphäre ist subjektivierter und betont stärker die Erwartungen, Wünsche und Vorstellungen des Einzelnen. Selbst zum gleichen Zeitpunkt innerhalb des gleichen Landes können die Erwartungen von Individuen bzgl. des Schutzes der Persönlichkeit stark auseinanderdriften. Das Recht muss somit People Analytics nicht im Keim ersticken, sondern einen Weg finden, um die kontextuellen Normen zur Privatsphäre zu respektieren. Im Arbeitsverhältnis existieren unzählige solcher Kontextnormen, die je nach Arbeitsumgebungen, Beschäftigungsarten und Erwartungen der einzelnen Arbeitnehmer und Arbeitgeberinnen verschieden sind. Beispielsweise ist denkbar, dass die Mitarbeiter eines IT-Unternehmens, das People Analytics-Anwendungen entwickelt, eher gewillt sind, sich auswerten zu lassen, da sie auf diese Weise die selbst entwickelten Produkte testen können. Auch könnte die Bereitschaft zur Überwachung höher sein in Berufen, die ohnehin schon beaufsichtigt sind, etwa durch die Finanzmarktaufsicht. Von der Arbeitgeberin ist Fingerspitzengefühl gefordert, um die Erwartungshaltung ihrer Arbeitnehmer an die Privatsphäre einschätzen zu können.

b) Psychische Integrität

Zur psychischen Integrität gehört der seelisch-emotionale Lebensbereich einer Person, der von zahlreichen äusseren und inneren Einflüssen bestimmt wird. Unterschieden werden die Teilgehalte des seelischen Wohlbefindens und der psychischen Gesundheit. Ersteres bezeichnet einen Zustand der positiven Gefühle und Stimmungen, Letztere eine Abwesenheit von besonders schweren psychischen Beanspruchungen, die psychiatrische Krankheitsfolgen nach sich ziehen können. In vielen Berufen findet eine Verschiebung von vormals physischen zu überwiegend psychischen Anforderungen statt. People Analytics tangiert die psychische Integrität, wenn beispielsweise durch permanente Ortung des Arbeit-nehmers ein erheblicher psychischer Überwachungsdruck, Stress und eine Einschränkung der Bewegungsfreiheit entstehen. Stress ist die hauptsächliche negative Auswirkung von intensivierten technischen Überwachungen auf die Psyche des Arbeitnehmers.

c) Recht am eigenen Wort und Bild

Von People Analytics betroffen sein kann auch das Recht am eigenen Wort und an der eigenen Stimme, das den Schutz der verbalen Lebensäusserungen vor heimlicher Aufnahme, Manipulation und Weiterverbreitung an einen anderen als den zu erwarteten Personenkreis bezweckt. Ein weiterer Persönlichkeitsaspekt ist das Recht am eigenen Bild, welches zur Bestimmung über die Verwendung jeder Gestaltungsform und Darstellung, mit deren Hilfe ein Abbild geschaffen werden kann, berechtigt, also namentlich fotografische oder filmische Aufnahmen. Das Recht am eigenen Wort und Bild wird beispielsweise tangiert, wenn Instrumente zur Stimmanalyse oder Videokameras bei People Analytics verwendet werden.

3.4 Diskriminierungen

3.4.1 Problembeschreibung

People Analytics bringt nicht immer die Objektivität in die Personalentscheidungen hinein, die verheissen wird. Der Interpretation von Daten haftet immer etwas Subjektives an: Die Lichtstrahlen, die dem Datenempfänger das Abbild eines Wortes im Auge liefern, durchlaufen beim Lesenden einen komplexen inneren Prozess, der aus dem physikalischen Input (z.B. aus den Buchstaben «B-a-l-l») ein Bild (Ball) macht, wobei jeder Leser an etwas anderes denken kann (kugelförmiges Sportgerät oder festliche Tanzveranstaltung). Bei der Herstellung von «Verständnis» begegnet der eingehende Impuls einem Vorrat an früher erworbener Information, Zeichen- und Sprachkompetenz. Für die Frage der Objektivität ist somit entscheidend, wie bei People Analytics die Daten interpretiert und die Techniken angewendet werden.

People Analytics birgt von Natur aus ein Risiko für Diskriminierungen in sich, weil gestützt auf Statistiken, scheinbar rational, zwischen Individuen «unterschieden» wird (lat. discriminare: (geistig) unterscheiden, trennen, absondern). Die Arbeitnehmer werden durch Profiling in Kategorien unterteilt, und Personalentscheidungen treffen jeweils Kategorien von Mitarbeitern mit vorbestimmten Profilen. Die algorithmischen Modelle unterscheiden stets zwischen Gewinnern und Verlierern: Suchresultate gibt der Algorithmus in einer Rangfolge bekannt, weil die Programmierung ihm befiehlt, die Informationen über Arbeitnehmer nach Relevanz zu sortieren. Wiederholt sind Vorurteile bzgl. Rassen- und Geschlechtszugehörigkeit in der Personalverwaltung nachgewiesen worden. Die erwähnten Versprechen betreffend mehr Objektivität durch Algorithmen werden daher entweder direkt bestritten oder zumindest in Zweifel gezogen.

3.4.2 Begriffserklärung

Der Begriff der Diskriminierung ist verfassungsrechtlich nicht legaldefiniert. Hingegen findet sich eine Legaldefinition im internationalen Recht: Als Diskriminierung gilt jede Unterscheidung, Ausschliessung oder Bevorzugung aufgrund verpönter Gründe, welche dazu führt, die Gleichheit der Chancen oder der Behandlung in Beschäftigung oder Beruf aufzuheben oder zu beeinträchtigen. Verpönte Merkmale sind namentlich Rasse, Hautfarbe, Geschlecht, Glaubensbekenntnis, politische Meinung, nationale Abstammung und soziale Herkunft. Ist eine solche Unterscheidung in den Erfordernissen der Beschäftigung begründet, gilt sie nicht als Diskriminierung (vgl. Art. 1 Abs. 1–2 Übereinkommen 111).

Es ist zwischen direkter und indirekter Diskriminierung zu differenzieren. Eine direkte Diskriminierung besteht, wenn eine Differenzierung zwischen Menschen ausdrücklich an ein verpöntes Merkmal anknüpft und nicht mit qualifizierten Gründen gerechtfertigt werden kann. Eine indirekte Diskriminierung liegt vor, wenn eine nach dem Wortlaut neutrale Massnahme in ihren praktischen Auswirkungen eine Gruppe von Menschen mit einem verpönten Merkmal wesentlich stärker als alle anderen trifft, ohne dass dies sachlich begründet wäre. Während bei der direkten Diskriminierung die individuelle Dimension interessiert, stehen bei der indirekten Diskriminierung die Ergebnisse betreffend die Gruppe im Fokus.

Im Kontext von People Analytics ist die indirekte die relevantere Form von Diskriminierung, da die Algorithmen tendenziell seltener explizit an verpönte Merkmale anknüpfen, sondern Arbeitnehmer nach neutralen Kriterien einteilen. Da die indirekte Diskriminierung nur widerrechtlich ist, wenn sie eine Gruppe wesentlich stärker trifft als eine andere, ist zu klären, wann diese Schwelle der Wesentlichkeit erreicht ist. Die schweizerische Rechtsprechung legt zur Feststellung, ob eine geschützte Gruppe wesentlich stärker benachteiligt wird, keine starren Grenzwerte fest; Kriterien zur Feststellung sind Werte aus Statistiken und die allgemeine Lebenserfahrung. Die europäische Rechtsprechung handhabt dies gleich. Das amerikanische Common Law wiederum orientiert sich noch stärker an statistischen Grenzwerten, was dort jedoch auf Kritik stösst.

3.4.3 Ursachen der algorithmischen Diskriminierung

a) Diskriminierungen während des gesamten Daten-Lebenszyklus

Die Ursachen, die zu einer indirekten Diskriminierung führen können, sind entlang des gesamten Daten-Lebenszyklus, vor allem aber in der Phase der Datenanalyse zu verorten. Die Phase der Datenanalyse dient der eigentlichen Entscheidfindung mithilfe eines Algorithmus und ist weiter zu unterteilen in die Teilphasen «Eingabe» (input), «Modell zur Datenanalyse» und «Ausgabe» (output). In der Eingabephase werden die Daten aufbereitet. Der grösste Teil der personenbezogenen oder nichtpersonenbezogenen Eingabedaten dient dazu, den (Roh-)Algorithmus zu trainieren (sog. Trainingsdaten), während der kleinere verbleibende Datensatz erst später in den Algorithmus eingeführt wird, um zu testen, ob dieser richtig funktioniert (sog. Testdaten), bevor er in der Praxis zum Einsatz kommt. In der Modellphase werden die real zu untersuchenden Daten durch den Algorithmus bewertet und interpretiert. Die Ausgabephase beschreibt den Prozess, bei dem gestützt auf die vom Modell errechneten Ergebnisse Entscheidungen getroffen oder Massnahmen angeordnet werden. Auf die drei Teilphasen und die damit einhergehenden Diskriminierungsrisiken ist nun näher einzugehen.

b) Diskriminierungen in der Eingabephase

Zunächst ist es möglich, dass die in der Eingabephase verwendeten Trainingsdaten an Mängeln leiden, etwa weil sie schlecht ausgewählt, unvollständig, doppelt, nichtrepräsentativ, subjektiv voreingenommen, veraltet oder falsch sind. Dies will die vorliegende Arbeit anhand des Signalproblems und des Problems historischer Stereotypen illustrieren.

Den Trainingsdaten kann es wegen des sog. Signalproblems an Repräsentativität fehlen. Die bei People Analytics verwendeten Daten lassen diejenigen Gruppen ausser Acht, die ihre Interessen nicht «signalisieren» (können). Mit People Analytics droht eine systematische soziale Ausgrenzung der Menschen, die aufgrund von Armut, Geographie oder Lebensstil weniger Daten über sich selbst produzieren als die durchschnittliche Bevölkerung. Prädiktive Algorithmen bevorzugen diejenigen Menschengruppen, die in den Trainingsdaten üppig repräsentiert sind, da mit diesen Vorhersagen weniger Unsicherheit verbunden ist. Beispielsweise sah sich die Swisscom mit dem Problem auseinandergesetzt, dass die Hälfte ihrer Belegschaft ihre Teilnahme an einem Smart Data-Pilotprojekt verweigert hat, mit dem das Unternehmen herausfinden wollte, welche Art von Zusammenarbeit Stress verursacht. Auch mangelnder Zugang zu Internet, Computer und Smartphones kann zu Ungleichheiten und Diskriminierungen führen. Arbeitgeberinnen müssen erforschen, wie sich solch verschiedene Zugangsmöglichkeiten auf die Trainingsdaten auswirken. D.h., es genügt nicht, bloss die vorhandenen Daten zu kennen. Stattdessen muss die Arbeitgeberin auch ermitteln, welche Daten ihr fehlen und ob sie gewisse Gruppen vergisst, die keine Datensignale von sich geben. Angesichts des auf europäischer Ebene neu eingeführten Rechts auf Vergessenwerden (Art. 17 DSGVO) mag dies paradox klingen: Aber das Diskriminierungsrecht pocht auf das «Recht, nicht vergessen zu werden».

Selbst in einem repräsentativen Datensatz können sich Diskriminierungen einschleichen: Historische Stereotypen der Gesellschaft können sich in den Trainings-Datensätzen fortsetzen und gar verschärfen, weil die Algorithmen die in vergangenen Daten enthaltenen Vorbilder nachahmen. Dies zeigt sich etwa bei Programmen zur Stimmerkennung und Sprachanalyse: Die Wörter «weiblich» und «Frau» werden mehr mit Geisteswissenschaften verbunden; «männlich» und «Mann» dagegen mehr mit Mathematik und Ingenieurberufen. Euro-amerikanische Namen sind in Sprachmustern eher mit angenehmen, afroamerikanische mit unangenehmen Begriffen verbunden. Der Algorithmus schlägt infolgedessen bei identischen Lebensläufen mit 50 Prozent höherer Wahrscheinlichkeit die Einladung zu einem Bewerbungsgespräch vor, wenn der Name des Bewerbers euro-amerikanisch ist. Die medizinische Fakultät St. George’s der University of London nutzte bereits in den 1980er-Jahren einen Algorithmus zur Bewerbungsselektion, um aufgrund früherer Bewerbungen vorherzusagen, wem eine erfolgreiche Arztkarriere beschieden sei. Das System neigte dazu, Frauen und Bewerber mit nichteuropäisch klingenden Namen ungeachtet ihrer akademischen Leistungen abzulehnen. Der Algorithmus von Amazon hat sich beigebracht, dass männliche Kandidaten vorzuziehen sind, und wertete Bewerbungen ab, in welchen Begriffe wie «Frauen-Schachclub» oder Namen von Frauen-Colleges vorkamen. Und auch Google zeigt Inserate für gut bezahlte Stellen Männern überproportional häufiger an als Frauen.

c) Diskriminierendes Modell

Das mathematische Modell ist der Schritt zwischen Eingabe- und Ausgabephase, bei welchem die eingegebenen Daten mit einer Wertung versehen, analysiert und in einen Entscheidvorschlag umformuliert werden. Zunächst fliessen das Weltbild und die Überzeugungen der betreffenden Programmierer in die Modellierung ein. Somit können Algorithmen die Vorurteile der Programmierer widerspiegeln und an Fehlern leiden. Nehmen die Programmierer gewisse Begriffe nicht in das Modell auf, droht der Algorithmus, Bewerbungen fälschlicherweise wegen fehlender Schlüsselwörter auszusortieren, obwohl sie zum Stellenprofil passen würden. Die Sicht des Algorithmus ist stets auf diejenige des Programmierers beschränkt. Der Algorithmus kann sich nicht in die Situation des Betroffenen versetzen und ignoriert beispielsweise, dass die Mutter eines Arbeitnehmers gerade im Spital liegt und dieser Umstand auf die Stimmung und Leistung des Arbeitnehmers drückt.

Ein Diskriminierungsrisiko besteht, selbst wenn auf diskriminierungsrelevante Attribute verzichtet wird. Der Verzicht schliesst zwar eine direkte Diskriminierung aus; die Gefahr einer indirekten Diskriminierung besteht aber weiter. Denn die verbleibenden Attribute können Stellvertreter geschützter Merkmale sein (sog. stellvertretende oder «Proxy-Variable», daher auch «Proxy-Diskriminierung»). Bereits relativ triviale Informationen können eng mit geschützten Charakteristika korrelieren. Beispielsweise korrelieren Facebook-Likes mit Geschlecht und politischer Gesinnung oder verwendeter Wortschatz mit Rasse. Eine weitere Ausprägung der indirekten Diskriminierung am Arbeitsplatz ist die Geokodierung (auch weblining, abgeleitet von redlining, dem Ziehen von roten Linien auf Landkarten im Zusammenhang mit der Vergabe von Finanzkrediten). Hier kann die Arbeitgeberin aus dem neutralen Kriterium der Wohnadresse des Betroffenen auf dessen ethnische Zugehörigkeit schliessen, wenn in gewissen Quartieren vorwiegend Personen der gleichen Ethnie wohnen. Wie schon angesprochen stellte das Software-Unternehmen Evolv fest, dass Mitarbeiter, die 0–5 Meilen von ihrem Arbeitsplatz entfernt wohnen, um 20 Prozent länger ihrer Stelle treu bleiben als diejenigen, die weiter weg wohnen. Die Arbeitgeberin kann auf diesem Weg die Demografie ihres Bewerberpools beeinflussen, indem sie etwa Stelleninserate nur für Personen mit einer bestimmten IP-Adresse freischaltet.

Diskriminierungen können sich ferner aus einem unzureichenden Stand der Technik ergeben: So erteilte eine Software zur Sprachanalyse in einem Call-Center Nichtmuttersprachlern und Arbeitnehmern mit starkem Sprachakzent oder einer Sprachbehinderung eine tiefere Bewertung, weil der Algorithmus die Sprechgewohnheiten nicht einordnen konnte. Oder das US-amerikanische behördliche System E-Verify verweigert fälschlicherweise Arbeitsbewilligungen, weil es mit Namen von Ausländern und Frauen, die nach der Heirat den Namen wechseln oder mehrere Nachnamen tragen, nicht zurechtkommt. Des Weiteren können Homonyme, also gleichlautende Wörter, die für verschiedene Begriffe stehen, zu Verwechselungen führen: Als ein Forschungsteam 2011 die Arbeitslosenquote der USA ermittelte, indem es in sozialen Netzwerken nach Begriffen wie «jobs» suchte, verzerrte die zeitgleiche Flut von Beiträgen zum Tod von Apple-Gründer Steve Jobs die Forschungsergebnisse. Ein Algorithmus kann zudem nur Grössen berücksichtigen, die nach dem Stand der Technik messbar sind. Hierzu zählen beispielsweise Verkaufszahlen, Produktionszeit und Dienstalter. Schwieriger ist etwa die Messung, wie gut ein Lehrer seine Klasse motivieren kann. Weil eine Evaluation an amerikanischen Schulen dies übersah und die Lehrpersonen weitgehend aufgrund der Prüfungsresultate der Schüler einstufte, kam es zu zahlreichen ungerechtfertigten Entlassungen.

Schliesslich können Diskriminierungen aus Übersetzungsschwierigkeiten zwischen der Rechts- und der Computerwissenschaft hervorgehen. In der Literatur fehlt eine einheitliche formelhafte Definition von Diskriminierung für Programmierer und Computerwissenschaftler. Diese Berufsgattungen haben verschiedene mathematische Definitionen von Gerechtigkeit vorgeschlagen. Die verschiedenen Perspektiven bei der Einschätzung, welches Kriterium das richtige sein soll, schliessen sich teilweise gegenseitig aus, sodass Kompromisse unumgänglich sind, wie anhand der folgenden drei Problemfelder aufzuzeigen ist.

Erstens besteht ein Konflikt zwischen der Gerechtigkeit für die Gruppe und für Einzelpersonen. Es ist angeblich statistisch erwiesen, dass die besten Informatiker diejenigen mit einer Vorliebe für Manga-Comics sind. Daher erscheint es aus Gruppenperspektive gerecht, die Gruppe der Manga-Liebhaber gegenüber dem Rest bei der Bewerbung oder bei Beförderungen zu bevorzugen. Auf Individualebene kann es jedoch ungerecht sein, einem talentierten Informatiker, der keine Manga liest, sein Talent abzusprechen. Der Algorithmus muss sich entscheiden, ob er einen Entscheid fällt, der für die Gruppe oder für die Einzelpersonen gerecht ist. Auch eine Mischrechnung ist denkbar, sodass etwa die maximal vorstellbare Gerechtigkeit für die Gruppe zu 60 Prozent und diejenige für den Einzelnen zu 40 Prozent erfüllt werden.

Zweitens ist die Gerechtigkeit zwischen verschiedenen Gruppen zu verteilen, was insbesondere in Fällen der Proxy-Diskriminierung Mühe bereiten kann: Ein Algorithmus mag beispielshalber errechnen, dass ein Arbeitnehmer, dem die negative Eigenschaft X fehlt, bessere Leistungen als andere Angestellte erbringt. Daraufhin stellt sich jedoch heraus, dass die Bevorzugung aller, denen die Eigenschaft X fehlt, gleichzeitig eine Benachteiligung aller Arbeitnehmer mit einem verpönten Merkmal Y bedeutet (Proxy-Diskriminierung). Dies könnte zutreffen, wenn X bedeutet, dass jemand immer etwas früher als die Kollegen die Arbeit verlässt, und Y bedeutet, dass die Angestellte eine Frau ist; alle im Betrieb angestellten Frauen sind zudem alleinerziehende Mütter, die früher gehen, weil sie am Abend ihre Kinder rechtzeitig von der Krippe abholen müssen. Hier muss dem Algorithmus beigebracht werden, ob er sich gegenüber der Gruppe derjenigen, denen die negative Eigenschaft X fehlt, oder gegenüber derjenigen mit dem verpönten Merkmal Y gerecht verhalten soll. Angezeigt ist in diesem Beispiel nicht eine Umprogrammierung des Algorithmus, sondern eine Flexibilisierung der Arbeitszeiten.

Drittens zeigt auch das sog. Simpson-Paradoxon, das einen scheinbaren Widerspruch zwischen der Gesamtpopulation und den Subpopulationen beschreibt, dass die Frage der Gleichbehandlung davon abhängt, wie man die Daten gruppiert. Nicht alles, was ungerecht aussieht, ist eine Diskriminierung: Facebook sah sich dem Vorwurf ausgesetzt, die Codes seiner Programmiererinnen zu 35 Prozent häufiger zurückzuweisen als diejenigen der männlichen Angestellten. Facebook entgegnete, dass mehrheitlich junge Frauen, die noch lernen und daher Kritik erhalten, bei Facebook arbeiten, während Frauen auf der Stufe Senior Engineering untervertreten sind. Nähme man statt der gesamten Belegschaft nur die Subpopulation der Jungen als Massstab, wäre das Risiko, kritisiert zu werden, für Frauen geringer als dasjenige für Männer.

d) Diskriminierungen in der Ausgabephase

Diskriminierend ist die falsche Folgerung von der Gruppenwahrscheinlichkeit auf den Einzelnen, weil sie eine Gleichbehandlung von Ungleichem bedeutet. Beispielsweise wäre es falsch, jemandem, der online nach einer Fritteuse sucht, ungesunde Essensgewohnheiten zu attestieren, da die Fritteuse möglicherweise als Geschenk für Dritte gedacht ist. Die Arbeitgeberin, die gesunde Angestellte rekrutieren will, würde übereilt und diskriminierend handeln, wenn sie solche Bewerbungen aussortieren würde.

3.5 Verletzung von Mitwirkungsrechten

3.5.1 Zweck und zwingende Geltung der Mitwirkungsrechte

In allen Fragen des Gesundheitsschutzes am Arbeitsplatz sind die Mitwirkungsrechte zu berücksichtigen (Art. 48 Abs. 1 lit. a ArG). Zum Gesundheitsschutz zählt der für People Analytics typische Einsatz von Überwachungs- und Kontrollsystemen, die das Verhalten der Arbeitnehmer am Arbeitsplatz überwachen (vgl. Art. 26 ArGV 3). Die Mitwirkung der Arbeitnehmer auf betrieblicher Ebene wird gesetzlich einerseits durch das MitwG, andererseits durch Art. 37–39 ArG (sowie Art. 67–68 ArGV 1) betreffend Betriebsordnung geregelt.

Die Mitwirkung bezweckt die Information und Mitsprache der Arbeitnehmer in den Betrieben (vgl. Titel des MitwG). Sie bringt den Arbeitnehmern Teilhabe, Kontrolle und informationelle Mitbestimmung beim Einsatz von People Analytics. Umgekehrt kann die Arbeitgeberin in einem frühen Stadium die Akzeptanz geplanter People Analytics-Massnahmen abschätzen. Denn die Auffassungen zur Privatsphäre variieren sowohl zwischen den Betrieben als auch innerhalb desselben Betriebs. Zudem erhöht ein aktiver Dialog die Produktivität des Unternehmens.

Das MitwG ist als Rahmengesetz konzipiert, das im Wesentlichen die institutionellen Voraussetzungen der betrieblichen Mitwirkung normiert. In welchen Bereichen und in welchem Umfang Mitwirkungsrechte bestehen, steht in den entsprechenden Spezialgesetzen (OR, ArG). Wichtig ist, zu sehen, dass die betriebsverfassungsrechtlichen Rechte des MitwG relativ zwingendes Gesetzesrecht darstellen: Von den Mitwirkungsrechten (Art. 9–10 MitwG) darf nicht zuungunsten der Arbeitnehmer abgewichen werden, auch nicht durch Gesamtarbeitsvertrag (vgl. Art. 2 Satz 2 MitwG). Eine Abweichung zugunsten der Arbeitnehmer ist jedoch zulässig (Art. 2 Satz 1 MitwG, sog. Günstigkeitsprinzip). Die relativ zwingende und kollektive Natur der Mitwirkungsrechte bedeutet, dass nicht durch individuelle Einwilligungen auf sie wirksam verzichtet werden kann.

Eine Verwirkung dieser Rechte fällt ausser Betracht. Auch erlöschen die datenschutzbezogenen Mitwirkungsrechte nicht, wenn die Arbeitgeberin einen Datenschutzverantwortlichen bezeichnet, der unabhängig (ebenfalls) die betriebsinterne Einhaltung der Datenschutzvorschriften überwacht (vgl. Art. 11a Abs. 5 lit. e DSG; vgl. Art. 9 E-DSG, Art. 10 rev-DSG).

3.5.2 Informationsrecht

Die Mitwirkungsrechte können stufenweise in Informations-, Mitsprache- und Mitentscheidungsrechte unterteilt werden. Die schwächste Form der Mitwirkung stellt das Informationsrecht dar. Es besteht ein Anspruch auf rechtzeitige und umfassende Information über alle Angelegenheiten, deren Kenntnis Voraussetzung für eine ordnungsgemässe Erfüllung der Aufgaben der Arbeitnehmervertretung ist (Art. 9 Abs. 1 MitwG). Die Aufgaben der Arbeitnehmervertretung bestehen darin, gegenüber der Arbeitgeberin die gemeinsamen Interessen der Arbeitnehmer wahrzunehmen und Letztere regelmässig über ihre Tätigkeit zu informieren (Art. 8 MitwG). People Analytics betrifft in der Regel den gesamten Betrieb oder ganze Abteilungen, weshalb gemeinsame Arbeitnehmerinteressen angesprochen sind und ein Informationsrecht besteht. Abzugrenzen ist das Informationsrecht des Arbeitnehmerkollektivs von der Information und der Anleitung der individuellen Arbeitnehmer (Art. 5 ArGV 3), auf welche vorliegend nicht näher eingegangen wird.

Das Informationsrecht beschränkt sich auf die Mitteilung; ein Mitberaten ist ausgeschlossen. Die Bedeutung des Informationsrechts liegt darin, dass es die Voraussetzung für alle weitergehenden Formen der Mitwirkung ist. Die «umfassende» Information (Art. 9 Abs. 1 MitwG) muss somit zumindest hinreichend für die weitere Aufgabenerfüllung sein, die bei People Analytics in der Mitsprache besteht, wie noch gezeigt werden wird. Tendenziell dürfte eine stichwortartige Schilderung des People Analytics-Systems genügen, während etwa der Quellcode eines verwendeten Algorithmus von den legitimen Geheimhaltungsinteressen der Arbeitgeberin gedeckt bleibt, solange dessen Kenntnis für die Mitsprache beim Gesundheitsschutz nicht erforderlich ist. Jedenfalls besteht eine Verschwiegenheitspflicht hinsichtlich der betrieblichen Angelegenheiten, die jemand in der Eigenschaft als Arbeitnehmervertreter erfährt (Art. 14 MitwG). Die Information umfasst auch die Arbeitnehmerrechte im Zusammenhang mit der Bearbeitung von Personendaten. Hinzuweisen ist etwa auf Art. 328b OR, auf das Auskunftsrecht (Art. 8 DSG, Art. 23 E-DSG, Art. 25 rev-DSG) und auf behördliche Anordnungen zum Gesundheitsschutz (Art. 6 Abs. 2 Satz 2 ArGV 3).

Die Information muss rechtzeitig erfolgen (Art. 9 Abs. 1 MitwG). Rechtzeitig bedeutet frühzeitig. Angemessen erscheint ein Zeitpunkt, der die Arbeitnehmervertretung in die Lage versetzt, die weitergehenden Mitwirkungsrechte auszuüben, etwa durch Entwicklung eigener Vorschläge und Bedenken, die bei der Planung berücksichtigt werden können. Als allgemeiner Richtwert für eine angemessene Frist werden zwei Wochen erwähnt. Doch ist ein abstrakter zeitlicher Richtwert nach der vorliegend vertretenen Auffassung nicht tauglich. Vielmehr beurteilt sich nach Treu und Glauben (vgl. Art. 11 Abs. 1 MitwG) und den Umständen des Einzelfalls (z.B. Komplexität und Dringlichkeit der Fragen sowie konkrete Aufgabe der Arbeitnehmervertretung), ob eine Information rechtzeitig erfolgt. Das Bundesgericht hält eine Konsultationsfrist von 24 Stunden im Hinblick auf eine Massenentlassung für zu kurz. Bei People Analytics erscheint eine frühe Information als zumutbar, weil die Arbeitgeberin entsprechende Projekte in der Regel planmässig einführt. In der Praxis kommt es vor, dass die neuen Geräte und Softwares zunächst als Pilotprojekt mit einer Gruppe von freiwilligen Arbeitnehmern getestet werden. Erst wenn diese Testphase erfolgreich verlaufen ist, entscheidet die Geschäftsleitung, ob und in welcher Form sie die People Analytics-Anwendung im gesamten Unternehmen auf obligatorischer Basis einführen wird. Idealerweise wird die Arbeitnehmervertretung ins Pilotprojekt eingebunden. So ist ein genügend früher Zeitpunkt für den Beginn der Mitwirkung sichergestellt. Spätestens aber bevor entschieden wird, dass und in welcher Form das Projekt unternehmensweit lanciert werden soll, muss die Arbeitnehmervertretung informiert und ihr eine angemessene Zeit zum Einbringen von Vorschlägen gewährt werden.

Über die Form der Information äussern sich weder das ArG noch die ArGV 3. Möglich sind die mündliche Information an einer Sitzung der Arbeitnehmerve

rtretung oder an einer Betriebsversammlung, ein internes Schreiben oder eine E-Mail an die Arbeitnehmervertretung bzw. die Belegschaft, der Aushang eines Informationsschreibens ans schwarze Brett oder die Publikation in der Firmenzeitung. Aus Beweisgründen ist es vorzuziehen, die Information schriftlich zu dokumentieren.

3.5.3 Mitspracherecht

Ein umfassendes Mitspracherecht existiert bzgl. aller Fragen des Arbeitnehmer-Gesundheitsschutzes (Art. 10 lit. a MitwG i.V.m. Art. 48 Abs. 1 lit. a ArG; vgl. Art. 6 Abs. 3 Satz 1 ArG; Art. 6 ArGV 3). Diese Fragen schliessen People Analytics ein, weil die Überwachung der Arbeitnehmer eine Frage des Gesundheitsschutzes ist (vgl. Art. 26 ArGV 3). Wenn diesbzgl. Betriebsbesuche der Vollzugsbehörde stattfinden, gilt ebenfalls das Mitspracherecht.

Das Mitspracherecht geht eine Stufe weiter als das Informationsrecht. Es umfasst den Anspruch auf Anhörung und Beratung (Art. 48 Abs. 2 ArG). Anhören bedeutet, dass die Arbeitnehmer das Recht haben, (einseitig) Vorschläge zu unterbreiten (Art. 6 Abs. 1 Satz 2 ArGV 3). Der Begriff des Beratens bedeutet «gemeinsam überlegen und besprechen». Die Arbeitgeberin muss sich im (wechselseitigen) Dialog mit den Vorschlägen der Arbeitnehmerseite auseinandersetzen, ehe sie entscheidet. Es genügt nicht, dass die Arbeitgeberin die Anliegen der Arbeitnehmerseite bloss zur Kenntnis nimmt. Die Arbeitgeberin ist jedoch nicht verpflichtet, den Vorschlägen der Arbeitnehmer zu folgen. Dies ergibt sich aus dem Anspruch auf Begründung des Entscheids, wenn dieser den Einwänden der Arbeitnehmerseite nicht oder nur teilweise Rechnung trägt (Art. 48 Abs. 2 Teilsatz 2 ArG).

Heikel ist die Frage, wer innerhalb des Unternehmens die Arbeitnehmer anhört (und wer nicht). Dies ist im Einzelfall festzustellen und dürfte von Unternehmen zu Unternehmen verschieden sein. Idealerweise tritt diejenige Person ins Gespräch mit der Arbeitnehmerseite, welche befugt ist, den infrage stehenden Entscheid auszuführen.

Über die Form der Anhörung äussert sich das Gesetz nicht. Die Arbeitnehmer können ihre Anliegen und Vorschläge mündlich oder schriftlich einbringen. Für die Beratung erscheint der mündliche Weg naheliegend. Aufgrund der Beweisbarkeit empfiehlt es sich aber, den Ablauf des Konsultationsverfahrens und das Ergebnis der Konsultation schriftlich genau zu dokumentieren.

Zeitlich muss die Anhörung erfolgen, bevor die Arbeitgeberin den Entscheid trifft (Art. 48 Abs. 2 ArG). Für den unbestimmten Rechtsbegriff der «frühzeitigen» Anhörung (Art. 6 Abs. 1 ArGV 3) kann an die Ausführungen zur rechtzeitigen Information erinnert werden.

Zu ergänzen ist, dass die aktive Rolle in der Mitsprache die Verpflichtung der Arbeitnehmer mit sich bringt, die Arbeitgeberin in der Durchführung der Vorschriften über den Gesundheitsschutz zu unterstützen (Art. 6 Abs. 3 Satz 2 ArG i.V.m. Art. 10 ArGV 3). Dies umfasst insbesondere eine Meldepflicht, wenn der Arbeitnehmer Mängel feststellt, welche den Gesundheitsschutz beeinträchtigen (Art. 10 Abs. 2 Satz 2 ArGV 3).

3.5.4 Fehlendes Mitentscheidungsrecht

Die stärkste Form der Mitwirkung ist das Mitentscheidungsrecht. Hier haben die Arbeitnehmer bzw. deren Vertretung das Recht, sich unmittelbar am Entscheidungsprozess zu beteiligen, wobei das Ausmass der Mitentscheidung variieren kann. Mitentscheidungsrechte haben Arbeitnehmer namentlich in Bezug auf die Arbeits- und Ruhezeit (z.B. Art. 10 Abs. 2 Satz 1 ArG) und den Sonderschutz für schwangere Frauen und stillende Mütter (z.B. Art. 35a Abs. 1 und 3 ArG). Im Zusammenhang mit der Überwachung am Arbeitsplatz sieht das Gesetz jedoch kein Mitentscheidungsrecht vor (vgl. Art. 6 Abs. 3, Art. 48 ArG). Diese Rechtslage entspricht den Anforderungen des Europarats und der IAO an die Mitwirkung bei der automatisierten Bearbeitung von Daten über Arbeitnehmer. Durch das Ausbleiben von Mitentscheidungsrechten bei People Analytics unterscheidet sich die Rechtslage in der Schweiz aber von derjenigen in Deutschland und Österreich.

3.6 Zwischenfazit: Rechtsprobleme vom Kontext abhängig

People Analytics forciert das Machtungleichgewicht in Arbeitsverhältnissen. Dies kann zu rechtlich problematischen Folgeerscheinungen wie Persönlichkeitsverletzungen, Diskriminierungen oder Verletzungen der Mitwirkungsrechte führen. Diese Probleme betreffen sowohl Individuen (bei Persönlichkeitsverletzungen und direkten Diskriminierungen) als auch Gesellschaftsgruppen (bei indirekten Diskriminierungen und Verletzungen von Mitwirkungsrechten).

Doch nach der vorliegend vertretenen Meinung sind nicht immer Rechtsprobleme mit People Analytics verbunden. Beispielsweise hängen die subjektiven Erwartungen an den Schutz der Privatsphäre vom Kontext ab, sodass die identische Anwendung in einem Betrieb zu Privatsphäreverletzungen führen kann, im andern jedoch nicht. Ferner kann etwa eine Anwendung aus der Sicht einer Einzelperson diskriminierend sein, während sie für gesamte Gruppen von Betroffenen gerechte Resultate hervorbringt. Daher ist eine differenzierte Sicht auf People Analytics erforderlich. Es kann nicht das Ziel sein, People Analytics von Grund auf zu verbieten. Stattdessen sind rechtliche Optionen gesucht, die der sich versteifenden Machtasymmetrie entgegenwirken und die nötige Flexibilität in die Arbeitsbeziehungen zurückbringen. Zur Prüfung dieser Optionen ist im Folgenden zunächst zu fragen, welche rechtlichen Erlasse überhaupt für People Analytics relevant sind (dazu sogleich).

Gabriel Kasper in: People Analytics in privatrechtlichen Arbeitsverhältnissen, Vorschläge zur wirksameren Durchsetzung des Datenschutzrechts; 2021; Dike Verlag, Zürich

https://creativecommons.org/licenses/by-nc-nd/3.0/ch/

DOI: https://doi.org/10.3256/978-3-03929-009-3

Zur einfacheren Lesbarkeit wurden die Quell- und Literaturverweise entfernt.